Лабораторна

робота №5-6

Тема: Умовна ентропія

Мета: навчатися визначати часткову і загальну умовну ентропію

дискретного джерела повідомлень

Теоретичні відомості

Умовна ентропія

Раніше отримана формула ентропії визначає її середньою кількістю

інформації, що припадає на одне повідомлення джерела статистично незалежних

повідомлень. Така ентропія називається безумовною.

Як відомо з відповідного розділу математичної статистики, мірою порушення

статистичної незалежності повідомлень x

і у є умовна ймовірність p(x/y) появи повідомлення xi за умови, що вже вибрано

повідомлення yj або умовна

ймовірність появи повідомлення yj,

якщо вже отримане повідомлення xi,

причому в загальному випадку p(x/y)¹p(y/x).

Умовну ймовірність можна отримати з безумовної ймовірності p(x)

чи p(y) та сумісної ймовірності системи в. в. p(x, y) за формулою множення ймовірностей:

p(x, y)=p(x)×p(y/x),

p(x, y)=p(y)×p(y/x),

звідси

![]() ,

,

![]() .

.

В окремому випадку для статистично незалежних повідомлень маємо: p(y/x)=p(y), p(x/y)=p(x).

При існуванні статистичної залежності між повідомленнями джерела

факт вибору одного з повідомлень зменшує або збільшує ймовірності вибору інших

повідомлень до умовних ймовірностей. Відповідно змінюється й кількість

інформації, що міститься в кожному з цих повідомлень. Ентропія такого джерела також

змінюється відповідним чином, причому обчислюється ентропія за тією самою

формулою, але вже з урахуванням умовних ймовірностей. Така ентропія називається умовною.

Властивості умовної ентропії

1) якщо джерела повідомлень X і Y статистично незалежні, то умовна ентропія джерела X стосовно Y дорівнює безумовній ентропії джерела X і навпаки:

H(X/Y)=H(X), H(Y/X)=H(Y);

2) якщо джерела повідомлень X і Y настільки статистично взаємозв'язані, що виникнення одного з повідомлень спричиняє безумовну появу іншого, то їхні умовні ентропії дорівнюють нулю:

H(X/Y)=H(Y/X)=0;

3) ентропія джерела статистично взаємозалежних повідомлень (умовна ентропія) менша від ентропії джерела незалежних повідомлень (безумовної ентропії):

H(X/Y)<H(X), H(Y/X)<H(Y).

Часткова умовна ентропія

Часткова

умовна ентропія - це кількість

інформації, що припадає на одне повідомлення джерела X за умови встановлення факту вибору джерелом Y повідомлення yj, або кількість інформації, що припадає на одне

повідомлення джерела Y за умови, що відомий

стан джерела X:

![]()

![]()

де ![]() ,

, ![]() - алфавіти повідомлень; xi - певне повідомлення джерела X,

щодо якого визначається часткова умовна ентропія H(Y/xi)

алфавіту Y за умови вибору

джерелом X повідомлення xi; yj - певне повідомлення джерела Y,

щодо якого визначається часткова умовна ентропія H(X/yj) алфавіту X за умови вибору повідомлення yj; i - номер повідомлення з алфавіту X; j - номер повідомлення з алфавіту Y; p(xi/yj), p(yj/xi) – умовні імовірності.

- алфавіти повідомлень; xi - певне повідомлення джерела X,

щодо якого визначається часткова умовна ентропія H(Y/xi)

алфавіту Y за умови вибору

джерелом X повідомлення xi; yj - певне повідомлення джерела Y,

щодо якого визначається часткова умовна ентропія H(X/yj) алфавіту X за умови вибору повідомлення yj; i - номер повідомлення з алфавіту X; j - номер повідомлення з алфавіту Y; p(xi/yj), p(yj/xi) – умовні імовірності.

Загальна

умовна ентропія

Визначається

так:

![]() ,

,

![]() .

.

Отже, загальна умовна

ентропія – це середньостатистична кількість інформації (математичне

сподівання), що припадає на будь-яке повідомлення джерела X, якщо відомий його статистичний взаємозв'язок з джерелом

Y. Так само загальна умовна ентропія - це середня

кількість інформації, яка міститься в повідомленнях джерела Y за наявності статистичного взаємозв'язку з джерелом X.

Приклади виконання завдань

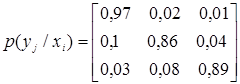

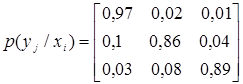

Приклад_1. Матриця

умовних ймовірностей каналу зв'язку між джерелом X і спостерігачем Y

має вигляд

.

.

Знайти

часткову та загальну умовні ентропії повідомлень у цьому каналі, якщо задано

розподіл ймовірностей джерела Px={0,65; 0,3; 0,05}.

Розв'язання

Умовні ймовірності p(yj/xi)

при i=j характеризують вплив завад у

каналі зв'язку.

Часткова

умовна ентропія спостерігача Y щодо джерела X визначається за формулою

![]() .

.

Знайдемо

часткові

умовні ентропії для всіх xi, i=1, …,3

![]()

![]() (біт/сим);

(біт/сим);

![]()

![]() (біт/сим);

(біт/сим);

![]()

![]()

![]() (біт/сим).

(біт/сим).

Знаходимо загальну умовну ентропію

дискретної випадкової величини (д. в. в.) Y стосовно д. в. в.

X:

![]()

![]() (біт/сим).

(біт/сим).

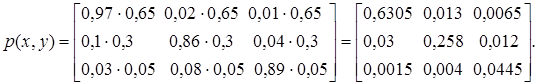

Скориставшись формулою множення

ймовірностей

p(xi, yj)=p(xi)×p(yj/xi),

побудуємо матрицю ймовірностей

системи д. в. в. X, Y:

Перевіряємо умову

нормування:

Перевіряємо умову

нормування: ![]() = 0,6305+0,013+0,0065+

= 0,6305+0,013+0,0065+

+0,03+0,258+0,012+0,0015+0,004+0,0445=1.

З матриці сумісних ймовірностей p(x, y) знаходимо взаємну ентропію д. в. в. X, Y:

![]()

![]()

![]()

![]()

![]()

![]() (біт/сим).

(біт/сим).

Скориставшись заданим рядом

розподілу ймовірностей д. в. в. X, знайдемо ентропію X:

![]()

![]() (біт/сим).

(біт/сим).

Перевірка: H(X, Y)=HX+H(Y/X)=1,142+0,385»1,527 (біт/сим).

Виконавши в матриці сумісних

ймовірностей pij= p(x, y) згортку за i, отримаємо приблизний

безумовний розподіл д. в. в. Y:

![]() ;

;

![]() ;

;

![]() .

.

Перевіряємо умову нормування

p(y1)+ p(y2)+ p(y3)=0,662+0,275+0,063=1.

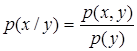

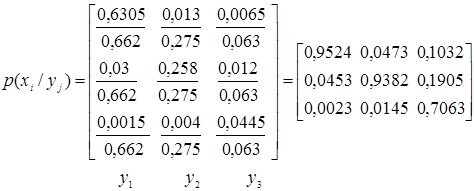

Знаючи

приблизний безумовний закон розподілу Py={0,662; 0,275;

0,063}, знайдемо матрицю умовних ймовірностей p(x/ y), скориставшись

формулою

.

.

.

.

Перевіряємо умови нормування:

![]() ;

;

![]() ;

;

![]() .

.

Виходячи

з розподілу безумовних ймовірностей д. в. в. Y, знайдемо ентропію

Y:

![]()

![]() (біт/сим).

(біт/сим).

З

матриці умовних ймовірностей p(x/ y) знайдемо часткові

умовні ентропії

д. в. в. X

стосовно д. в. в. Y:

![]()

![]() (біт/сим);

(біт/сим);

![]()

![]() (біт/сим);

(біт/сим);

![]()

![]() (біт/сим).

(біт/сим).

Тоді

загальна

умовна ентропія X стосовно Y

![]()

![]() (біт/сим).

(біт/сим).

Перевірка:

H(X, Y)=HY+H(X/Y)=1,157+0,369=1,527 (біт/сим).

Відповідь: H(Y/x1)»0,222 (біт/сим);

H(Y/x2)»0,705 (біт/сим);

H(Y/x3)»0,593 (біт/сим);

H(Y/X)»0,385 (біт/сим); H(X/y1)»0,289 (біт/сим); H(X/y2)»0,383 (біт/сим); H(X/y3)»1,148 (біт/сим); H(X/Y)»0,369 (біт/сим).

Завдання

на лабораторну роботу

Завдання

1.

Дослідження каналу зв'язку між

джерелом X і спостерігачем Y виявило такі умовні ймовірності вибору

повідомлень yjÎY:

.

.

Знайти часткові

H(X/yj) і загальну H(X/Y) умовні ентропії повідомлень у цьому

каналі, якщо джерело задане ансамблем {x1,

x2, x3} з ймовірностями {0,3;

0,2; 0,5}.

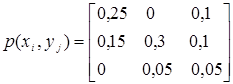

Завдання 2.

Два статистично

залежних джерела X та Y визначаються матрицею сумісних

ймовірностей

.

.

Знайти часткові

й загальну умовні ентропії H(X/yj),

H(X/Y) і взаємну інформацію I(X, Y).

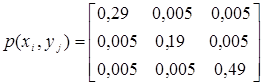

Завдання 3.

Матриця

сумісних ймовірностей каналу зв'язку має вигляд

.

.

Знайти часткові

й загальну умовні ентропії H(X/yj),

H(X/Y) і взаємну інформацію I(X, Y).

Завдання 4

Знайти ентропії д. в. в. X, Y,

Z і кількість інформації, що містить

д. в. в. Z=2X+Y

стосовно X та Y. X, Y – незалежні д. в. в.,

задані такими розподілами ймовірностей:

|

X |

-1 |

0 |

1 |

|

Y |

0 |

1 |

2 |

. |

|

P |

1/4 |

1/2 |

1/4 |

P |

1/6 |

2/3 |

1/6 |

Завдання 5

Дискретна випадкова

величина (д. в. в.) X1

може набувати три значення: -1, 0 і 1 з однаковими ймовірностями. Д. в. в. X2 з однаковими ймовірностями

може набувати значення 0, 1 і 2. X1

і X2 – незалежні, Y=X12+X2. Знайти кількість

інформації I(X1,Y), I(X2,Y) і ентропії HX1, HX2,

HY.

Завдання 6

Дискретна випадкова

величина (д. в. в.) X

з різною ймовірністю може набувати значень від 1 до 8. Д. в. в. Y набуває значення 0, якщо X парне, і 1, якщо X непарне. Знайти кількість інформації I(Y, X) і ентропію HX, якщо д. в. в. X задана таким розподілом ймовірностей:

|

X |

1 |

2 |

3 |

4 |

5 |

6 |

7 |

8 |

. |

|

P |

0,1 |

0,2 |

0,1 |

0,05 |

0,1 |

0,05 |

0,3 |

0,1 |

Після виконання

завдань оформити та здати звіт викладачу